“不要让网络成为多节点并行计算效率的瓶颈。”

hpc为啥要用ib网?这个说法其实并不准确,应该问:hpc为啥要用rdma?

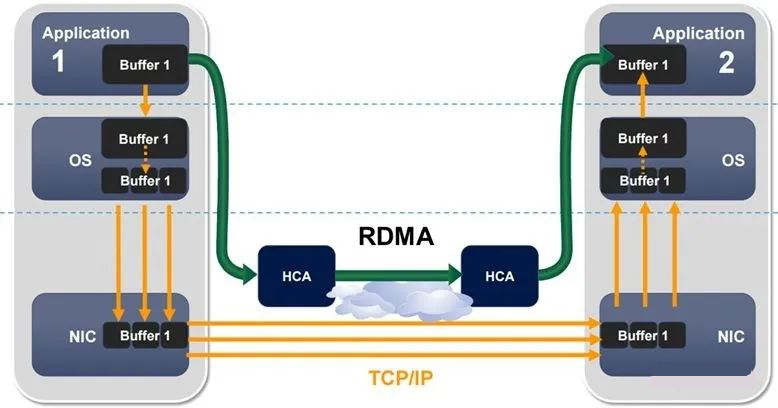

高性能计算(hpc)集群中多节点并行时,核与核之间需要通过计算网络实时通信,这就要求计算网络具有大带宽、低延时的特性。而传统以太网tcp/ip的通信方式,需要将数据传输到操作系统内核,然后再从内核复制到目标计算机的内存中,不仅延迟较高,而且还占用了cpu的计算资源。

rdma(remote directly memory access)则可以在不经过操作系统内核的情况下将数据从一个计算机直接传输到另一个计算机的内存中。这种直接访问内存的方式可以避免操作系统内核的干扰,从而减少了延迟和cpu使用率。

目前支持rdma的网络协议有:

infiniband(ib): 从一开始就支持rdma的新一代网络协议。由于这是一种新的网络技术,因此需要支持该技术的网卡和交换机。

rdma融合以太网(roce): 即rdma over ethernet, 允许通过以太网执行rdma的网络协议。这允许在标准以太网基础架构(交换机)上使用rdma,只不过网卡必须是支持roce的特殊的nic。

互联网广域rdma协议(iwarp): 即rdma over tcp, 允许通过tcp执行rdma的网络协议。这允许在标准以太网基础架构(交换机)上使用rdma,只不过网卡要求是支持iwarp的nic。

在三种主流的rdma技术中,可以划分为两大阵营。一个是infiniband(ib)技术, 另一个是支持rdma的以太网技术(roce和iwarp)。其中, infiniband行业协会(ibta)力挺的技术自然是ib和roce, mellanox公司(一个以色列人搞的公司, 于2020年4月被nvidia斥资68亿美元收购)是这方面的先驱者。而iwarp则是ieee/ietf力挺的技术,主要是chelsio公司在推进。

高性能计算(hpc)需要处理大量的数据和计算任务,因此需要使用高效的网络通信技术来实现快速数据传输和低延迟的计算。无疑是最适合ib网络的应用场景。可以说ib网络是专为hpc而生。